2022 ficará na história como o ano em que a Inteligência Artificial foi reconhecida pelas suas capacidades criativas.

No dia 30 de novembro a OpenAI colocou na rede, em acesso gratuito, um assistente de IA, o ChatGPT, que em apenas 5 dias conseguiu mais de um milhão de utilizadores, alimentados pela curiosidade de contactar com as suas capacidades extraordinárias de conversação. No meio dos muitos defeitos que lhe fomos encontrando —erros factuais, invenção de dados, excesso de confiança, ou falta de “voz” —, todos tivemos de reconhecer que nunca tínhamos visto nada igual. É possível entrar em diálogo com o assistente, conversar sobre a mais ampla gama de assuntos e gerar momentos de profunda partilha empática construída a partir da autoilusão com base na naturalidade, eloquência e compreensão discursiva do assistente.

Mas não foi apenas a conversação que foi tomada de assalto. Meses antes, a 12 de julho, tinha sido divulgado um outro assistente, o Midjourney, depois, a 22 de agosto, era também divulgado o Stable Diffusion da Ludwig Maximilian University de Munich, e ainda a 28 de setembro, a OpenAI disponibilizava a todos o Dall-E 2. Estes três assistentes de IA partilham as mesmas competências de desenho de imagens, com a particularidade de apresentarem resultados originais, simultaneamente muito humanos, como se tivessem sido criados por seres humanos.

A conversação e o desenho são atividades bastante próximas e profundamente criativas. Do mesmo modo como vamos improvisando com um lápis num papel, assim vamos improvisando na criação de respostas, em tempo real, às interações com o outro. Por isso, interessa perceber o que originou estas novas capacidades das máquinas, tendo em conta que a IA já andava por aí há quase 70 anos.

Até há alguns anos, construía-se IA a partir de meros algoritmos, como se estivéssemos a esculpir um modelo do pensar, na expectativa de chegar a algo capaz de reconhecer o mundo e a si mesma. Mas os desenvolvimentos de IA começaram a mudar com o Deep Blue que para vencer Garry Gasparov, em 1997, estudou milhares de jogadas de xadrez antes. Desde então a abordagem passou a focar-se na aprendizagem, no ensino e auto-ensino dos sistemas de IA, o Machine Learning (ML), para o que a internet veio contribuir com o acesso a cada vez maiores bases de dados. O processo de treino da IA foi transformacional, não só porque permitiu aos assistentes encontrar padrões parecidos e assim descobrir a chave do significado por meio da mera comparação, mas especialmente, porque deste processo se desenvolvem as chamadas redes neurais artificiais, em que cada conceito ou ideia é interligada a centenas de outras ideias por meio de parâmetros apreendidos pela própria IA.

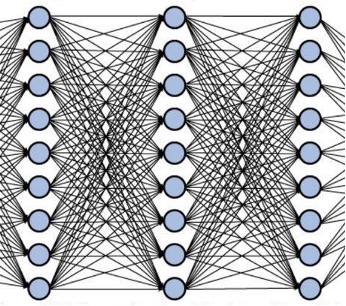

De forma simplista, quando olhamos para uma caneta, conseguimos estabelecer pouco mais de 4 a 6 parâmetros que a definam — ex. cor: azul; efeito: metálico; brilho: dourado; comprimento: 7cm; largura: 0,5cm. Já um assistente, munido de um conjunto de algoritmos de ML, consegue, por meio de comparações estabelecidas dentro dessas enormes bases de dados, encontrar e definir não apenas algumas dezenas, mas mesmo centenas de parâmetros que definem a mesma caneta (ver Figura 1). Parâmetros que nós, humanos, podemos não conseguir, de forma consciente, ver, ouvir, sentir ou sequer compreender. Mas são esses parâmetros que permitem acesso a uma realidade imensamente fina, provavelmente inacessível ao cérebro humano, que possibilita ao assistente prever as melhores palavras a escrever, umas a seguir às outras, assim como a melhor cor, traço, sombra, volume, escala a assumir no desenho de uma imagem.

Figura 1: Camadas múltiplas de parâmetros, e suas interligações, numa rede neural profunda. O GPT-3, que é o sistema mais avançado do momento, é constituído por 96 camadas de neurónios artificiais, totalizando 175 mil milhões de interconexões [1].

Naturalmente, este processo de aprendizagem a partir de grandes bases de dados criadas por seres humanos apresenta grandes problemas que vão dos vieses embebidos aos direitos autorais dos conteúdos nelas presentes. Se no texto o viés se torna rapidamente claro, com os assistentes a regurgitar muitos dos preconceitos morais que trespassam a internet, é nas imagens que mais problemas se têm levantado. Os assistentes estão a usar bases de dados de imagens, como a LAION, criadas para efeitos de investigação científica. Como o objetivo era o de construir assistentes o mais avançados possíveis, e assim contribuir para a inovação humana, foi permitido a estas bases de dados catalogarem praticamente tudo aquilo que iam encontrando na net.

i miss this tool: https://manytools.ai/

ResponderEliminar